הסכנה בהגבלה של פיתוח מערכות מבוססות בינה מלאכותית לצרכים צבאיים

"אָמַר רַבִּי יוֹחָנָן: מִיּוֹם שֶׁחָרַב בֵּית הַמִּקְדָּשׁ, נִטְּלָה נְבוּאָה מִן הַנְּבִיאִים וְנִתְּנָה לְשׁוֹטִים וּלְתִינוֹקוֹת"

(בבא בתרא, יב: 2)

מערכות נשק מבוססות בינה מלאכותית משמשות בעשורים האחרונים כר פורה לסרטי פעולה ופנטזיה. כיום אין הגדרה מוסכמת למונח "בינה מלאכותית".2 במאמר זה נגדיר אותה: "מערכת המסוגלת לפתור בצורה רציונלית בעיות מורכבות או לנקוט פעולות, כדי להשיג את מטרותיה בנסיבות שונות בהן היא נתקלת בעולם האמיתי".3

העלייה בהיקף הפעילות האזרחית והצבאית במרחב הקיברנטי, החיבור הרשתי של מגוון הולך וגדל של מכונות ומכשירים, מסדי הנתונים ההולכים וגדלים והעלייה המעריכית בכוח העיבוד של המחשבים בעשורים האחרונים, יצרו את התנאים לפיתוחן של מערכות מבוססות בינה מלאכותית (ראו: שרטוט 1) המאפשרת להפוך לעובדה קיימת תפקודים, שבעבר נחשב יישומם האוטונומי על־ידי מחשבים למדע בדיוני.4

מטרת המאמר לטעון כי הקריאה להגביל או למנוע פיתוח של מערכות בינה מלאכותית לצרכים צבאיים פסולה ומסוכנת; טענה זו תוצג באמצעות התמודדות עם הטיעונים המשפטיים הייחודים למערכות אלה ובאמצעות הצגת יתרונותיהן בהתאם לאבני היסוד של העשייה הצבאית.

שרטוט 1: בשרטוט מוצגים יחסי הגומלין בין מערכות רובוטיות אוטונומיות למערכות בינה מלאכותית הנשענות על מסדי הנתונים הקיימים במרחב הקיברנטי. (הערת שוליים 5)

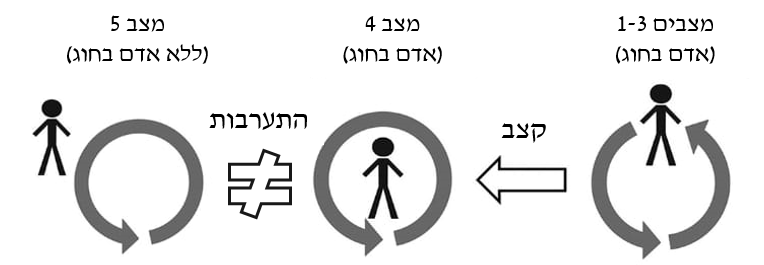

בשלהי שנות ה־80 של המאה ה־20 פורסם על־ידי חוקרי התנהגות ארגונית מארצות־הברית מדד המציג את יחסי אדם-מכונה,6 ובו כלולים הגורמים הבאים:7

* שליטה ידנית. ללא סיוע תבוני של המכונה. למשל מערכת "רואה יורה", טיל "גיל" או כטמ"מ.

* מערכת תומכת החלטה. ההחלטות מתקבלות על־ידי המפעיל, על־פי המלצה של המערכת.

* מערכת תבונית למחצה. מתקיימת מודעות מצבית משותפת בין המערכת והמפעיל, אך המערכת לא תמשיך לפעול ללא אישורו.

* בינה מלאכותית מבוקרת. המערכת פועלת באופן אוטונומי, ללא מודעות מצבית משותפת בין האדם למכונה התבונית, עד התערבות של מפעיל אנושי.

* אוטונומיה מלאה. המערכת פועלת באופן אוטונומי, ללא מודעות מצבית משותפת בין האדם והמכונה התבונית וללא בקרה, אך האדם יכול לכבותה בכל עת.

כיום, היישומים הצבאיים של הבינה המלאכותית באים לידי ביטוי בכלים תומכי החלטה בחלק ממערכות המידע של אמ"ן, במערכות השו"ב ובאמצעים תומכי לחימה כמו "הדק חכם". כך גם במערכות לחימה אוטונומיות למחצה המקיימות מודעות מצבית משותפת עם המפעיל - המקבל את ההחלטות ומתערב בפעילות המכונה, כמו: מערכות טייס אוטומטי ומערכות נשק אוטונומיות למחצה.8

שרטוט 2: במצבים 3-1 קצב קבלת ההחלטות משמר את הרלוונטיות של המודעות המצבית המשותפת בין האדם למכונה. במצב 4 קצב קבלת ההחלטות אינו מאפשר מודעות מצבית משותפת אלא בקרה בלבד. (הערת שוליים 9)

המערכות שבהן דן המאמר הן רובוטים אוטונומיים10 (מצב 5) ומערכות נשק מבוססות בינה מלאכותית הפועלות במרחב הסב"ר; מערכות נשק משולבות המבצעות התקפות קינטיות באמצעות רובוטים יחד עם התקפות סייבר בממד הלחימה הקיברנטי.11 זאת לאור התובנה כי בכוחן לשנות פרדיגמות ולעשות מהפכה של ממש בשדה הקרב.12

אמנם הטכנולוגיה המאפשרת תפקודים אלה טרם הבשילה13 ולא ברור מתי תבשיל,14 אך במקביל להאצת תהליכי בניין כוח ברחבי העולם בתחום זה גם גוברים החששות מפני תרחישים אפוקליפטיים בהם הגולם יקום על יוצרו.15 חששות אלה באים לידי ביטוי בשיח על אודות הסיכונים וההזדמנויות, יחד עם קריאות לאיסור גורף על פיתוח מערכות בינה מלאכותית,16 קל וחומר לעסוק ביישום צבאי של בינה מלאכותית17 ואף הידרדרות לאיום בחרם אקדמי על מוסד שחוקר את התחום.18

אופנה זו יצרה תופעה של הטלת רגולציה עצמית במערב;19 בעוד שיש מדינות שלא מטילות על עצמן, ככל הידוע, רגולציה עצמית בתחום זה כמו: רוסיה20 וסין.21 כך נוצר מצב מסוכן שבו אותן מדינות מקדמות את התחום, בעוד המערב עוסק בהלקאה עצמית. בשלב זה בשיח אקדמי ובמגזר הפרטי בלבד, אך ככל שהמשקל הסגולי של האקדמיה והתעשיות במחקר ובפיתוח של הבינה המלאכותית עולה,22 כך הסכנה שהדבר עשוי לזלוג למגזר צבאי ולצמצם את היתרון האיכותי מול האויב גוברת.

סכנה זו אינה תיאורטית. הקוד האתי של פיתוח מערכות נשק מבוססות בינה מלאכותית שנכתב עבור מערכת הביטחון האמריקנית ממליץ על הימצאות אדם בחוג ובכך מרוקן, הלכה למעשה, את יתרונותיה המובהקים של הבינה המלאכותית מתוכן.23

הגבלות על לוחמה קיברנטית כמקרה בוחן לאסדרה לא אפקטיבית

ייחודו של ממד הלחימה הקיברנטי טמון בהיותו מלאכותי24 ושעצם קיומו, הנשען על תשתיות תקשוב בין־לאומיות, מותנה באסדרה הנחוצה לתפקודו התקין.25 במקביל, ואולי כמענה להשמעת קולות בצבא26 ובאקדמיה27 הקוראים לאסדרת הפעילות והלוחמה במרחב הסב"ר, החלו הליכי חקיקה פנימית וחיצונית במערב אירופה, בישראל, ברוסיה ובסין במטרה "למשטר" את הפעילות האזרחית בממד זה.28 בשני העשורים האחרונים זכו תקיפות סייבר של שחקנים מדינתיים ולא מדינתיים לסיקור נרחב בתקשורת. חלק מן התקיפות גרמו לנזק כלכלי בלבד, אך לפחות במקרה אחד, המיוחס על־ידי תקשורת זרה לארצות־הברית ולישראל, הובילו להשחתה פיזית של צנטריפוגות בכור גרעיני באיראן.29

לדוגמה, לוחמת המידע בממד הקיברנטי, במיוחד של סין ורוסיה, הבליטה את חוסר המענה של דיני המלחמה ללוחמה זו - מה שהוביל לפרסום "מדריכי טאלין" על־ידי פורום מומחים בין־לאומי עבור ברית נאט"ו בשנים 2013 ו־2017. המדריך הראשון התייחס ללוחמה קיברנטית במהלך עימות מזוין, בעוד השני נגע בלוחמה קיברנטית שלא במסגרת עימות מזוין.30

מדריכים אלה, שלהם אין מעמד מחייב, מיסדו לכל היותר את ההכרה בתקיפה קיברנטית כמקבילה לתקיפה קינטית, בנסיבות מסוימות, שעשויה להוות עילה למלחמה. הלכה למעשה לא ניתן להביא ראיות לכך שמדריכים אלה הביאו לאסדרה של התחום או לריסון תקיפות אלה.31 יתרה מכך, אפשר להעריך כי אילו רוסיה הייתה מבצעת תקיפה קיברנטית נרחבת נגד אסטוניה, גם לאחר כתיבת "מדריכי טאלין", ההסתברות שברית נאט"ו הייתה יוצאת למלחמה נגדה תוך היאחזות בעילה זו קלושה ביותר. דוגמה נוספת היא חברת NSO הנותנת שירותי תקיפת סייבר ללקוחות מדינתיים ואשר, לדבריה, השיתה על עצמה רגולציה עצמית וקוד אתי המגביל את פעילותה.32

הואיל ולא ניתן להצביע על מגבלות אפקטיביות על לוחמה קיברנטית אפשר גם לטעון, כי המתווה המשפטי הקיים אינו נותן מענה מספק ללוחמה קיברנטית, וקל וחומר לא נותן מענה לסוגית הבינה המלאכותית בכלל והנשק האוטונומי המבוסס על בינה מלאכותית בפרט.33 למשל, בהינתן תאונת דרכים הנגרמת עקב תקלת תוכנה של רכב אוטונומי, מתעורר קושי משפטי בדבר ההצבעה על האחראי לתאונה -34 שיכול להוות הזדמנות ויתרון נוסף לשימוש במערכת.

הסבר אפשרי לחוסר ההצלחה באסדרת הלוחמה הקיברנטית ניתן למצוא בספרו של פאול שר Army of None ולפיו הניסיונות להגביל או לאסור פיתוח ושימוש באמצעי לחימה במהלך ההיסטוריה הצליחו רק כשהיה מדובר במערכות נשק לא מוצלחות. כל עוד מערכות הנשק היו מוצלחות והצדיקו את קיומן בשדה הקרב - נמשכו הפיתוח וההצטיידות בהן. (לדוגמה, נשק אטומי, כימי וביולוגי).35

לפיכך, ככל והלוחמה הקיברנטית מועילה, נראה שלמי שעושה בה שימוש אין אינטרס להגביל או לאסור אותה - מה שיכול להסביר את חוסר התוחלת בניסיונות שנעשו עד כה למשטר אותה.

התמודדות עם טיעונים הקוראים לאסור או להגביל את השימוש הצבאי בבינה המלאכותית

הטיעונים המשפטיים עמם המאמר מתמודד נבחרו בשל התייחסותם הספציפית למערכות נשק אוטונומיות מבוססות בינה מלאכותית;36 מה שעשוי להפוך אותם לרלוונטיים בערכאות משפטיות, גם בהיעדר חקיקה מפורשת בתחום, שעלולות להגביל או לאסור יישום צבאי של טכנולוגיה זו.37

שימוש בבינה מלאכותית כובל את שיקול הדעת ואסור בדין המנהלי.38 לפי הטיעון, המבוסס על פרשנות מרחיבה ומחמירה שלפיה פעולת לחימה היא פעולה מנהלית, הפעלת מערכת נשק אוטונומית אינה לגיטימית מכיוון שהיא כובלת את שיקול הדעת של מפעיל המערכת מהרגע שבו הופעלה - דבר האסור בדין המנהלי.

עובדתית, בצה"ל ובמשטרה נעשה שימוש בכלבים, לרבות כלבי תקיפה שלהם בינה נפרדת מזו של הכלבן. לפיכך, מרגע שהכלב נשלח ליעד שיקול הדעת של הכלבן המשלח כבול.39 כך, עשויים להיווצר מצבים שבהם אין מודעות מצבית משותפת בין האמל"ח40 למפעיל ולפי טיעון זה יש לאסור, או להגביל בצורה חמורה יותר, את השימוש בכלבי תקיפה במערכת הביטחון.41 יתרה מכך, יצירת מנגנון המתערב בפעילות המערכת האוטונומית לאחר הפעלתה הופך אותה ממערכת אוטונומית למערכת אוטונומית למחצה, ובכך מרוקן את הערך המוסף של הבינה המלאכותית מתוכן.42

לוחמת מיחידת עוקץ עם כלבה. צילום: דו"ץ

מערכת מבוססת בינה מלאכותית היא כוח אצור שלא ניתן לנבא את ההשלכות פעולתו.43 עם טיעון זה קשה יותר להתמודד, הואיל ואמצעי לחימה אלה עדיין אינם קיימים. עם זאת, בהינתן יכולת בינה מלאכותית העולה על יכולות אנושיות, לא מן הנמנע כי מערכות נשק אלו ינקטו שיטות פעולה שאותן לא ניתן לדמיין

אף על פי כן, גם אם מערכת נשק המבוססת בינה מלאכותית תפעל בצורה לא צפויה בממד הקיברנטי, ולפעילותה יהיו השלכות קינטיות כמו שיבוש מערכות תקשורת שיביאו לתאונות של מטוסים ורכבות; "השתלטות" על מערכות נשק לא מאוישות שיפגעו באוכלוסיה הישראלית ובכוחות צה"ל - יש לקחת תרחישי קיצון אלה בפרופורציות המתאימות: ככלל נזק מתקיפות סייבר הוא מוגבל והפיך, ניתן לפתח מנגנוני הגנה מתאימים למערכות שעשויות להיות פגיעות לתקיפות סייבר. נוסף על כך, למערכות נשק אוטונומיות ניתן לפתח מנגנון השמדה עצמית למקרה של אובדן תקשורת או השתלטות עוינת.44

יש לזכור כי הנזק שהרובוטים יכולים להסב מוגבל בסופו של דבר לחימוש שאותו הם נושאים. גם כאשר דנים בתרחישים שבהם בינה מלאכותית תייצר צבאות של רובוטים באמצעות מדפסות תלת־ממד, אין לשכוח כי חומרי הגלם הטעונים במדפסות ייגמרו בסופו של דבר.45

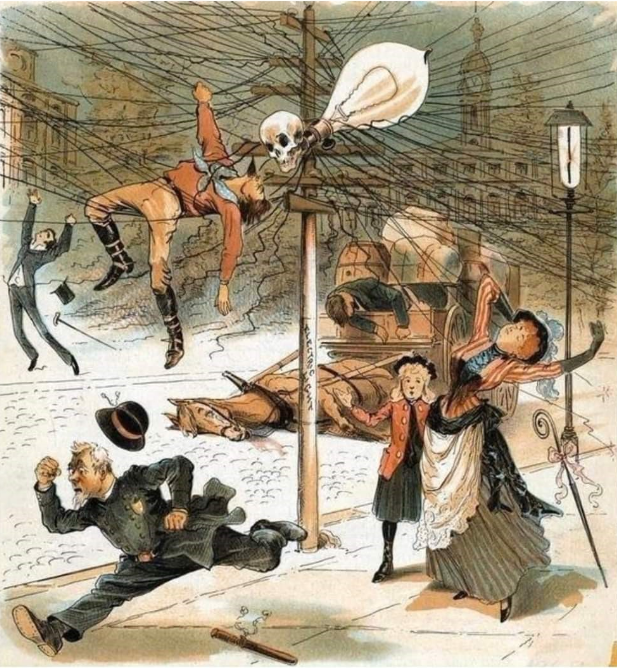

איור שהופץ על־ידי מתנגדי פריסת תשתיות החשמל בתחילת המאה ה־20, שחששו מהתחשמלויות המוניות. (הערת שוליים 46)

יתרונות בשימוש צבאי בבינה המלאכותית לפי אבני היסוד של העשייה הצבאית47

בדומה להתמודדות עם הטיעונים העומדים מאחורי הקריאות לאסור או להגביל מערכות נשק מבוססות בינה מלאכותית, להלן היתרונות הייחודיים למערכת:

אבן יסוד "אדם" יחד עם אבני יסוד "מידע" ו"זמן" - יכולות עיבוד.48 חומר רב נכתב הן על מגבלות אנושיות בעיבוד הנתונים הנגישים להם ועל המגבלות הנוגעות לקבלת ההחלטות לאור המידע העומד לרשותם לאור הטיותיהם האנושיות:49

* מערכות בינה מלאכותית צפויות להביא לשדה הקרב העתידי יכולות עיבוד וקבלת החלטות, אולי אף במצבים כאוטיים, החורגות מיכולות אנושיות50 בכך שיתמודדו עם כמויות אדירות של נתונים (ביג דאטה) בקבועי זמן קצרים ביותר, שהאויב לא יוכל להתמודד עמם.51

* מערכות בינה מלאכותית צפויות לקבל החלטות המנותקת מרגשות וממניעים אנושיים, ובכך לסייע בצמצום של פגיעה בבלתי מעורבים וביישום עקרונות ההבחנה, המידתיות, הצורך והאנושיות של הדין הבין־לאומי52 בשדה הקרב העתידי.53

אבן יסוד "עוצמה" (צבאית) - פיצוי על מחסור בכוחות לוחמים. כמות משמעותית של מערכות נשק אוטונומיות שיפעלו ללא צורך במפעיל, או צוות מפעילים, אנושי יוכלו לסייע בקיזוז החיסרון הכמותי ממנו מדינת ישראל סובלת ביחס לאויביה מיום הקמתה.54 לדוגמה, נחיל של רחפנים רובוטיים זעירים יוכל להשמיד יחידות אויב במהירות,55 בדגש על כוחות אויב מבוזרים הפועלים ללא מסגרות סדורות אשר פרוסים בשטחים גדולים ונטמעים באוכלוסייה האזרחית.

אבן יסוד "עוצמה" יחד עם אבני יסוד "אדם" ו"מידע" - ישות משפטית נפרדת. שימוש בבינה מלאכותית צפוי להיות בעתיד קפיצת מדרגה טכנולוגית משנת פרדיגמות. כך ייתכן וניתן יהיה להגדיר בתנאים מסוימים מערכות בינה מלאכותית כישויות משפטיות נפרדות,56 בדומה למדינות וחברות בע"מ.57 הדבר עשוי לסייע בשבירת שרשרת ההפללה58 בין המפקדים למערכות הנשק המשמשות אותם - ובכך יקנה להם חסינות מהפללה.59

אבן יסוד "שדה הקרב" - ממד הלחימה הקיברנטי. מאפייני מערכות הבינה המלאכותית, בדגש על תלותן במסדי נתונים מתעדכנים, יהפכו את המרחב הקיברנטי למרכזי יותר בשדה הקרב. הדבר יתבטא בהזדמנויות לפעילות התקפית שתכליתה לשלול יכולות אויב, והן כיעד להגנה אשר יחייב השקעת משאבים מתאימים לשימור יכולת זאת.60

הדמיה של נחיל רחפני נפץ

סיכום

בשנת 1882 הממציא האמריקני היירם מקסים פיתח את מכונת הירייה האוטומטית הראשונה – המקלע, שנקרא על שמו. הביקוש למקלע בצבאות אירופה היה נמוך הן בשל ריבוי מעצורים והן בשל כך שרבים ראו במקלע "נשק שאינו ג'נטלמני". עם זאת, לאחר שכוח בריטי קטן הצליח להביס כוח אפריקני הגדול ממנו פי שבעה באמצעות ארבעה מקלעי "מקסים" בלבד ב־1893, הבינו בכל צבאות אירופה את פוטנציאל הקטלניות של הנשק החדש. כך הפך המקלע לסמל ליתרון הטכנולוגי המשמעותי של אירופה על שאר העולם, וכפי שאמר זאת פזמון פופולרי באותן השנים: "לא משנה שום דבר אחר, לנו יש 'מקסים' ולהם - חסר".61

רצח העם בשלהי שנות ה־90 של המאה הקודמת ברואנדה נעשה באמצעי לחימה טרום־תעשייתיים: מצ'טות. עצירת הקִדמה כנראה לא תמנע את זוועות המלחמה, היא רק תשים את מי שיכבול את עצמו בנחיתות מול מי שלא יכבול את עצמו. טוב נעשה אם הדילמה היחידה עמה נתמודד תהיה איך נפעיל, אם נפעיל, את מערכות הנשק אשר יעמדו לרשותנו - ויאפשרו בעתיד לעבד נתונים ולקבל החלטות בקצב לא אנושי, יחד עם הפעלת נחילים רובוטיים אשר ישמידו אויב בזירות קרובות ורחוקות במהירות - ולא איך נתמודד מול מערכות נשק שאין לנו כי מנענו אותן מעצמנו.

כך, עם החששות המבוססים והלא מבוססים מהפוטנציאל העתידי של מערכות הנשק האוטונומיות מבוססות הבינה המלאכותית והאופנה הרווחת בחלק מהמדינות והתעשיות להתרחק מתחום זה, מדינת ישראל לא יכולה להרשות לעצמה להיות "הג'נטלמן של המזרח־התיכון"; עליה למקסם את כוחה ולהוביל במרוץ החימוש הזה.

לקבלת חומרים נוספים מבית "מערכות" לחצו כאן

הערות

-

ברצוני להודות לסא"ל אריאל הירש, סא"ל (מיל') ד"ר אלדד שמש, סא"ל (מיל') ד"ר דותן דרוק, ד"ר זאב אלרון, ד"ר לירן ענתבי, אע"צ אייל ברלוביץ', רע"ן לוחמ"מ מוד"ש, רס"ן אלון פישר, רס"ן דן קרינסקי וסא"ל גלעד כהן על הערותיהם על המאמר.

-

ההגדרה לבינה מלאכותית בצה"ל: כושר חשיבה או כושר ביטוי של מחשב או רובוט, הקרובים לאלה האנושיים. אמ"ץ-תוה"ד, המילון למונחי תורה צבאית, מטכ"ל-10-1, תש"ף-2020. הואיל וכבר קיימות מערכות כאלה – לא ייעשה שימוש בהגדרה במאמר זה.

-

Executive Office of the President National Science and Technology Council Committee on Technology, "Preparing for the Future of Artificial Intelligence", October 2016, accessed 5 February 2018.

-

יובל דרור, "בינה מלאכותית – התפתחות חיובית או איום קיומי?", חדשנות בישראל תמונת מצב, רשות החדשנות, 2017. עמ' 72-66.

-

נורית כהן אינגר וגל א' קמינקא, "והרי התחזית: צה"ל בדרך לצבא תבוני – מפת דרכים לאימוץ טכנולוגיות בינה מלאכותית בצה"ל", בין הקטבים 18 (דצמבר 2018). עמ' 99.

-

James Mattis, Human-Machine Teaming, Joint Concept Note 1/18, Ministry of Defence, May 2018. Page 47.

-

Mica R. Endsley, David B. Kaber, "Level of automation effects on performance, situation awareness and workload in dynamic control task", Ergonomic, (Vol 42, No3.) (1999). pp 464; Mica R. Endsley, "From here to autonomy: lessons learned from human-automation research", Human Factors, (Vol 59).( 2017).

-

נורית כהן אינגר וגל א' קמינקא, "והרי התחזית: צה"ל בדרך לצבא תבוני – מפת דרכים לאימוץ טכנולוגיות בינה מלאכותית בצה"ל", בין הקטבים (עורך ערן אורטל, גיליון 18), (דצמבר 2018). עמ' 91-118. להרחבה אודות היישומים המודיעיניים ראו יוסי קופרווסר ודודי סימן טוב, "ביג דאטה ומודיעין", מודיעין הלכה ומעשה, (גיליון 3), (מאי 2018).

-

[9] Paul Scharre, Army of none – Autonomous weapons and the future of war, w.w Norton & company. April 2018. pp 35-36.

-

הואיל ובמצבים 4-1 יש אדם בחוג ההחלטה, כפי שמתואר בשרטוט 2, מאמר זה לא ידון בהם.

-

אפשר שלכל רובוט יהיה "מוח" משלו, אפשר ש"מוח" ריכוזי ישלוט בנחיל של רובוטים ואפשר לתכנן מערכת משולבת-לומדת, אך הדיון על כך חורג מגבולות הכתיבה של המאמר.

-

דוד שורש, "אסטרטגיה בעידן הבינה המלאכותית – תהליך תכנון אסטרטגי למגמות טכנולוגיות משבשות", בין הקטבים (עורך ערן אורטל, גיליון 18), (דצמבר 2018). עמוד 122. ראו גם נורית כהן-אינגר, יאיר אדיב וזיו דיין, "מלחמת הדברים", מערכות, (גיליון 468-469), (נובמבר 2016), עמ' 11-13.

-

"התעשייה האווירית חשפה מל"ט מתאבד חדש", גלובס. 24 ביוני 2017.

-

Executive Office of the President National Science and Technology Council Committee on Technology, "Preparing for the Future of Artificial Intelligence", October 2016, accessed 5 February 2018. יחד עם-זאת, ד"ר זאב אלרון מצליח להפריך את הפרדיגמה אודות קצב השינויים המהיר במאמרו "האטת קצב השינויים הטכנולוגיים", מו"פ בטחוני בעולם (עורך יעקב צור), (פברואר 2020). עמ' 4-8.

-

Paul Scharre, Army of none - Autonomous weapons and the future of war, w.w Norton & company. April 2018. Chp 15.

-

אלון הסגל, "האם הבינה המלאכותית תוכל באמת להתמודד עם דילמות מוסריות ואתיות?", PC אנשים ומחשבים, יולי 2017.

-

סוכנויות הידיעות, "עובדים בגוגל התפטרו במחאה על מעורבותה בפרויקט בינה מלאכותית עבור הפנטגון", TheMarker, מאי 2018.

-

לא צוין, "חרם אקדמי: 'לעצור פיתוח חשאי של רובוט מחסל'", Ynet, 8 באפריל 2018.

-

Esther Chavannes, Klaudia Klonowska,Tim Sweijs, "Governing autonomous weapon systems", HCSS Security. (February 2020).

-

רפאל קאהאן, "פוטין: המדינה שתוביל בתחום ה־AI תשלוט בעולם כולו", כלכליסט, ספטמבר 2017.

-

"דיווח: מיקרוסופט משתפת פעולה עם צבא סין בפיתוחי בינה מלאכותית", כלכליסט, אפריל 2019.

-

Bianca Torossian, Frank Bekkers, Klaudia Klonowska, "Effective stakeholder cooperation during the lifecycle of robotic and autonomous systems", HCSS Security. (March 2020).

-

Defense Innovation Board, "AI Principles: Recommendations on the Ethical Use of Artificial Intelligence by the Department of Defense". 2020.

-

עמית שיניאק, "התהוות המדינה במרחב הספר המקוון: השוואה תיאורטית והיסטורית", בין הקטבים (2014). עמ' 44-13.

-

דבורה האוסן-כוריאל, "דיני הטלקומוניקציה הבינלאומית ודיני סייבר בינלאומיים", משפט בינלאומי (עורכים רובי סיבל ויעל רונן), (נבו). (2016).

-

שרון אפק, "שוברים את הכללים וכולם משחקים – על המפגש בין המרחב הקיברנטי לכללי המשפט הבינלאומי", בין הקטבים (2014). עמ' 78-67.

-

יעל רונן, "הפעילות במרחב הסייבר בראי המשפט הבינלאומי", סייבר, מודיעין וביטחון כרך 2, גיליון 3, (דצמבר 2018). עמ' 89-88; איתן דיאמונד, "החלת המשפט ההומניטארי הבינלאומי על לוחמת סייבר", משפט ובטחון לאומי – סוגיות נבחרות,INSS, מזכר 133, מרס 2014, עמ' 72-57.

-

גבי סיבוני ועידו סיון-סביליה, "רגולציה במרחב הסייבר", INSS, מזכר 180, אוגוסט 2018. עמ' 100-31.

-

אסף נקש, "מדיניות התגובה למתקפת טרור סייבר",( 2017). עמ' 16-19.

-

Tallinn Manual on The International Law Applicable to Cyber Warfare, Cambridge University Press, 2013; Tallinn Manual 2.0 on The International Law Applicable to Cyber Operations, Cambridge University Press, 2017.

-

במאמרו של נקש אפשר למצוא דוגמאות לתקיפות בממד הקיברנטי אשר אירועי גם לאחר כתיבת "מדריכי טאלין".

-

עומר כביר, "החוקר שחקר את הפריצה של NSO מדבר: 'בכל מקום שאנחנו בודקים, מדינות מרגלות נגד אזרחים'", כלכליסט, 4 בנובמבר 2019; שחר סמוחה, "תופעה: כמו סייבר התקפי, הימורים או פורנו מתקשות לגייס עובדים", גלובס, 7 בפברואר 2020.

-

Esther Chavannes, Amit Arkhipov-Goyal, Towards Responsible Auyonomy, HCSS Security. September 1019. Chpt 5. And Paul Scharre, Army of none – Autonomous weapons and the future of war, w.w Norton & company. April 2018. pp 242-243.

-

אושרית גן־אל, "תובע מחוזי: על אובר לא תוטל אחריות לתאונה בה רכב אוטונומי דרס הולכת רגל", גלובס, 7 במרס 2019; סתיו נמר, "הרכב האוטונומי של אפל היה מעורב בתאונת דרכים", מעריב, ספטמבר 2018.

-

Paul Scharre, Army of none – Autonomous weapons and the future of war, w.w Norton & company. April 2018. Part V.

-

קרין נהון, "ועדת משנה של המיזם הלאומי למערכות נבונות בנושא אתיקה ורגולציה של בינה מלאכותית - דין וחשבון", נובמבר 2019.

-

ס' 1 לחוק יסודות המשפט (תיקון מס' 1), תש"ם – 1980, ס"ח 2715. ס' 15 (ד) (2) לחוק-יסוד: השפיטה, תשמ"ד – 1984, ס"ח 1110.

-

אייל בנבנישתי ואליאב ליבליך, "לוחמה רובוטית ובעיית הכבילה של שיקול הדעת", עיוני משפט ל"ט, (2016).

-

בתנאים מסוימים הכלבן יכול להשפיע על הכלב לאחר שילוחו, אך לא תמיד ובכל מקרה בצורה מוגבלת.

-

אמנם התיאור לא נעים לעין אך בפעילות צבאית הכלב הוא, בסופו של דבר, אמל"ח.

-

אפשר להתמודד עם טענת הנגד המועלית בכך שברוב המקרים הכלבן הוא זה שבוחר את היעד עבור הכלב, בשונה ממערכת בינה מלאכותית אשר תוכל כנראה בעתיד לבחור יעדים לעצמה – אך כאמור, הגבלה מחמירה זו הנגזרת מהדין המנהלי תמנע ממערכות מבוססות בינה מלאכותית לשמש כמכפילי כוח.

-

[42] כפי שהומלץ בקוד האתי שנכתב עבור מערכות אוטונומיות בארצות־הברית. AI Principles: "Recommendations on the ethical use of artificial intelligence by the department of defense", defense innovation board, 2020.

-

גבי סיבוני ועידו סיון-סביליה, "רגולציה במרחב הסייבר", INSS מזכר 180, אוגוסט 2018, עמ' 118-103. אמנם המחקר לא עוסק בבינה מלאכותית ואינו קורא להגבילה, אך המתודולוגיה שלו מציגה את התשתית הרעיונות המשמשת את המתנגדים לפיתוח בינה מלאכותית בהתבסס על טיעון זה ועל האיסור לפגוע בסכרי מים לפי הפרוטוקול הרביעי (1977) של אמנת ז'נווה.

-

[44]Paul Scharre, Army of none – Autonomous weapons and the future of war, w.w Norton & company. April 2018. Part IV.

-

Ibid.

-

מתוך דף הפייסבוק של Omri S. M. Weil, אפריל 2020.

-

אמ"ץ-תוה"ד, אבני היסוד של העשייה הצבאית, מטכ"ל 9-תת-02. 2006.

-

יוסי קופרווסר, "הסייבר, בינה מלאכותית והמעשה המודיעיני", רואים מל"מ 58, (דצמבר 2019), עמ' 3-2.

-

אורי בר-יוסף, מתקפת פתע – מנהיגות ומודיעין במבחן העליון, כנרת זמורה-דביר. ספטמבר 2019.

-

Paul Scharre, Army of none – Autonomous weapons and the future of war, w.w Norton & company. April 2018. pp 282-290.

-

John Allen, Amir Hussain, "On Hyper-War", Fortuna's Corner. (July 2017).

-

אליאב ליבליך, אואן אלתרמן, "המשפט ההומנטירי הבינלאומי בעימותים מזוינים על-לאומיים וא-סימטריים: אתגרים עכשוויים מרכזיים", INSS, 2014.

-

Paul Scharre, Army of none – Autonomous weapons and the future of war, w.w Norton & company. April 2018. pp 257-262.

-

יעקב צור, "מערכות לא מאוישות – צבא ארה"ב בונה על חיילים "רובוטים"", מו"פ ביטחוני בעולם, לקט עיתונות, (משרד הביטחון), (יוני 2018). עמ' 34-33.

-

ניתן סדן, "רובו-רצח: כך ייראו הרחפנים בשדה הקרב", כלכליסט, 22 בנובמבר 2017.

-

ויקטור ח. בוגנים, "חוק המחשבים והתמודדות המשפט עם האתגר הטכנולוגי", שערי משפט (ד(2)). (2006). עמוד 10.

-

ישויות משפטיות אשר אינן אדם, היכולות לתבוע ולהיתבע בערכאות משפטיות.

-

נעם נוימן, "לוחמת משפט – איומים והזדמנויות", מערכות 449 (יוני 2013).

-

גם יתרון זה ניתן להציג כחסרון:Paul Scharre, Army of none – Autonomous weapons and the future of war, w.w Norton & company. April 2018. pp 241-244.

-

Ibid.

-

דף הפייסבוק, היסטוריה גדולה, בקטנה, 26 באוקטובר 2016.